Pourquoi bloquer le référencement d'une page ?

Créer des sites web seulement ne suffit pas. A priori quand on a rédigé un contenu et des pages on veut améliorer le positionnement de son site sur Google et autres moteurs de recherche. Vous avez envie que toutes les urls de votre site soient bien indexées et bien classées sur les pages de résultats de recherche (les SERPs). En plus de comment savoir si son site est bien référencé on doit aussi se poser la question d'empêcher l'indexation d'une page.

Cependant il existe de nombreux cas, dans le cadre du contrat de conception et de maintenance de site web, où vous devez absolument bloquer l'indexation de certains contenus de sites. Il s'agit des cas suivants:

- Textes à caractère confidentiel et accessible uniquement à un public privé (intranet, extranet...) qu'on ne veut absolument pas voir trainer sur le net

- Soumissions de formulaires

- Contenus obsolètes ou préjudiciables à l'image de votre activité

Comment interdire l'indexation d'un page ?

S'il s'agit de bloquer certaines pages de votre site le responsable du référencement du site internet a toute latitude pour contrôler l'indexation de votre contenu sur les moteurs de recherche. Les moyens à votre disposition sont:

- le robots.txt

- la balise méta robot

- le contrôle d'accès de vos contenus

Fichier ROBOTS.TXT pour le seo

Ce document robots.txt, placé à la racine de votre site web (Joomla! ou tout autre CMS), est un puissant outil pour l'optimisation on-site. Il indique aux bots des outils de recherche quelles sont les pages qui peuvent être indéxées ou non. Il faut le préparer en fin de mission de refonte de site web.

Ce document robots.txt, placé à la racine de votre site web (Joomla! ou tout autre CMS), est un puissant outil pour l'optimisation on-site. Il indique aux bots des outils de recherche quelles sont les pages qui peuvent être indéxées ou non. Il faut le préparer en fin de mission de refonte de site web.

Dès que le robot (le spider) d'un moteur arrive sur un site (ici http://www.monsite.com/), il va rechercher le document sur http://www.monsite.com/robots.txt avant d'effectuer la moindre "aspiration de document". S'il existe, il le lit et suit les indications qui y sont inscrites. S'il ne le trouve pas, il commence son travail de lecture et de sauvegarde de la page qu'il est venu visiter, considérant qu'a priori rien ne lui est interdit.

Il faut ajouter qu'une mauvaise configuration peut conduire à ruiner tous vos efforts sur le référencement naturel de votre site. Pire encore vous pouvez vous retrouver avec des contenus confidentiels indexés au grand dam des internautes qui pensaient remplir des formulaires en toute confidentialité!

La syntaxe à suivre pour le seo

Il ne peut exister qu'un seul document de ce type sur un site, et il doit se trouver au niveau de la racine. Le nom doit toujours être créé en minuscules et sa structure est la suivante :

User-agent: *

Disallow: /cgi-bin/

Disallow: /tmp/

Disallow: /cache/

Disallow: /administrator/

Disallow: /listing/clients.html

On voit ici :

- User-agent: * signifie que l'accès est accordé à tous les agents (tous les spiders), quels qu'ils soient.

- Le robot n'ira pas explorer les répertoires /cgi-bin/, /tmp/, /cache/ et /administrator/ du serveur ni /listing/clients. Le répertoire /tmp/, correspond à l'adresse http://www.monsite.com/tmp/. Chaque répertoire à exclure de l'aspiration du spider doit faire l'objet d'une ligne Disallow: spécifique. La commande Disallow: permet d'indiquer que "tout ce qui commence par" l'expression indiquée ne doit pas être indexé.

Ainsi :

Disallow: /cache ne permettra l'enregistrement ni de http://www.monsite.com/cache/index.php, ni de http://www.monsite.com/cache.php

Disallow: /cache/ n'indexera pas http://www.monsite.com/cache/index.php, mais ne s'appliquera pas à l'adresse http://www.monsite.com/cache.php

D'autre part, il ne doit pas contenir de lignes vierges (blanches).

L'étoile (*) n'est acceptée que dans le champ User-agent.

Elle ne peut servir de joker (ou d'opérateur de troncature) comme : Disallow: /entravaux/*.

Il n'existe pas de champ correspondant à la permission, de type Allow:.

Enfin, le champ de description (User-agent, Disallow) peut être indifféremment saisi en minuscules ou en majuscules.

Les lignes qui commencent par un signe dièse (#), ou plus exactement tout ce qui se trouve à droite de ce signe sur une ligne, est considéré comme étant un commentaire.

Voici quelques commandes et très classiques importantes à suivre:

| Disallow:/ | Permet d'exclure toutes les pages du serveur (aucune aspiration possible). |

| Disallow: | Permet de n'exclure aucune page du serveur (aucune contrainte). Un document vide ou inexistant aura une conséquence identique. |

| User-Agent : googlebot | Permet d'identifier un robot particulier (ici, celui du moteur Google). |

| User-agent: googlebot Disallow: User-agent: * Disallow:/ | Permet au spider de Google de tout aspirer, mais refuse les autres bots. |

Le fichier exemple pour le contrôle seo de Joomla!

Lors de l'installation d'un projet Joomla! un fichier type est livré par défaut. Il contient les lignes minimum pour la protection de votre site:

User-agent: *

Disallow: /administrator/

Disallow: /bin/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /layouts/

Disallow: /libraries/

Disallow: /logs/

Disallow: /modules/

Disallow: /plugins/

Disallow: /tmp/

Il faudra alors penser à ajouter toutes les familles d'url que vous ne voulez pas voir indexées par les solutions de recherche.

La balise meta robots

Il s'agit d'une balise meta pour informer sur la nature et le texte d’une page web, ajoutée dans l’en-tête de la page au moyen de marqueurs HTML. A la manière du fichier de contrôle des bots présenté ici, la balise meta est utilisée pour donner des directives aux solutions de recherche sur la manière d'explorer, indexer et parcourir les liens sur une page.

Exemple de balise meta robots :

<html> <head> <title>Titre de la page</title> <meta name="robots" content="noindex, nofollow"> </head>

La valeur noindex empêche la page d'être indexée et la valeur nofollow empêche les liens d'être suivis par les robots et de transmettre de la popularité.

Si vous souhaitez simplement bloquer l'enregistrement de la page mais laisser la possibilité aux bots de suivre les liens, il suffit de ne laisser que la valeur noindex :

<meta name="robots" content="noindex">

Les autres valeurs existantes

<meta name="robots" content="noarchive">

Cette balise permet de prévenir les outils de recherche que vous ne souhaitez pas qu'ils gardent une archive de la page. Sur Google, cela se traduit par l'impossibilité d'affichier le lien "En cache" associé à une page dans les résultats.

<meta name="robots" content="nosnippet">

La valeur "nosnippet" permet d'empêcher l'affichage d'un extrait (meta description) dans les résultats de recherche.

<meta name="robots" content="noodp">

Le "noodp" empêche les moteurs d'utiliser en remplacement le titre et/ou la description du site tirés du répertoire DMOZ.

Les attributs spécifiques à certains moteurs de recherche

Pour cibler Google le prestataire de référencement doit gérer la balise suivant :

<meta name="google" content="xxxx">

Lorsque le contenu d'une page web n'est pas dans la langue choisie par l'utilisateur, Google peut fournir dans les résultats de recherche un lien permettant d'accéder à une traduction. Avec cette balise meta "nostranslate", vous interdisez à Google de fournir une traduction de votre page.

<meta name="google" content="notranslate">

La valeur "unavailable_after" permet de préciser l'heure et la date exactes auxquelles l'exploration et l'indexation de la page doivent cesser :

<meta name="google" content="unavailable_after:[date]">

noimageindex permet d'indiquer que vous ne souhaitez pas faire apparaître votre page comme source d'une image apparaissant dans les résultats de recherche :

<meta name="google" content="noimageindex">

Pour cibler Yahoo! :

<meta name="Slurp" content="xxxx">

Comme la valeur "noodp", la valeur "noydir" empêche Yahoo! d'utiliser le titre et la description provenant de l'annuaire Yahoo! Directory.

<meta name="robots" content="noydir">

Pour cibler Bing / MSN :

<meta name="msnbot" content="xxxx"> <meta name="bingbot" content="xxxx">

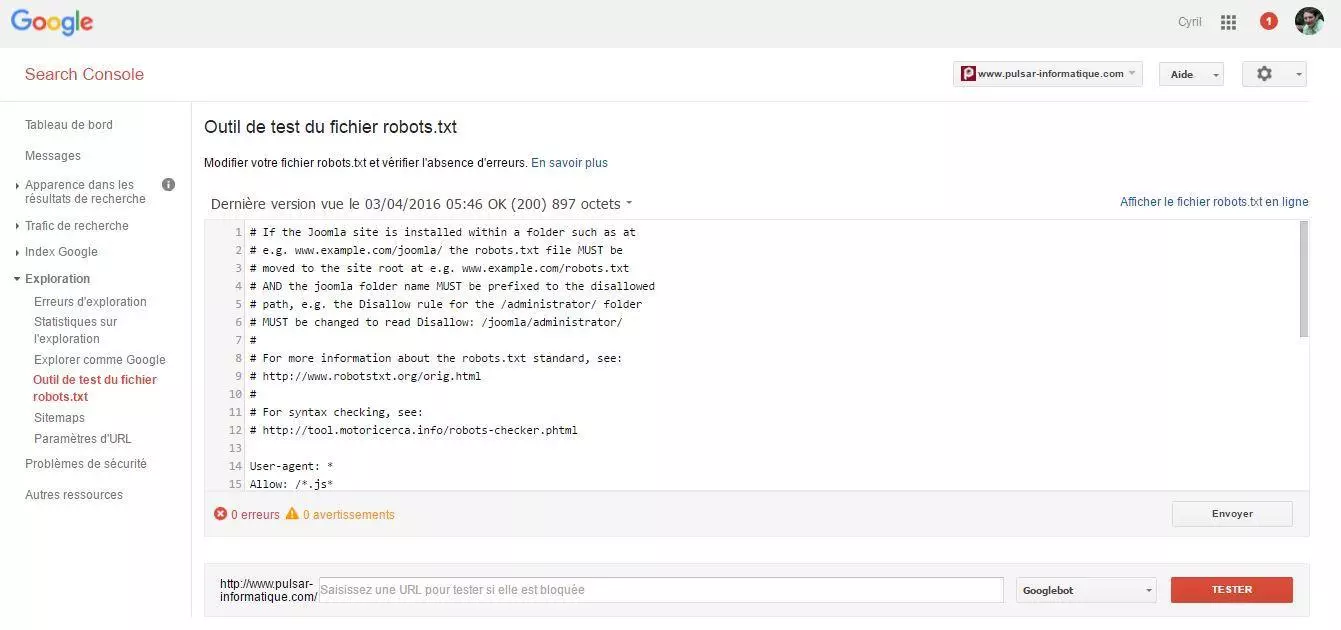

Comment tester votre fichier robots.txt

Depuis votre compte Google Web Master Tools vous avez la possibilité de tester l'intégrité de votre fichier robots.txt et vérifier si telle ou telle page est bien bloquée par le robot.

Vous aimerez aussi :

Combien coûte le référencement d'un site internet : Google indexe t-il bien gratuitement les pages de vos sites ?

Retrouvez tous nos articles sur :